Big Data hat inzwischen jede/r zur Genüge gehört, der/die sich mit der Digitalisierung auseinandersetzt. Und allen ist klar, dass in diesen Datenmengen großes Potenzial steckt. Wie aber ist es mit kleineren Datenmengen, die in KMUs oftmals vorliegen, in Unternehmen, in denen erst seit jüngerer Vergangenheit Fokus auf das Potenzial von Daten gelegt wird?

- Wer macht überhaupt Big Data?

- Wie viele Daten braucht es wirklich?

- Sales Forecasting mit Small Data

- Transfer Learning zur Abbildung der Saisonalität bei kurzen Zeitreihen

- Durch agile Entwicklung zu interpretierbaren Ergebnissen

- Weitere Anwendungsmöglichkeiten von Small-Data-Techniken

- Erfahrungen unserer Kunden

Wer macht überhaupt Big Data?

Jeder macht was mit “Big Data”. Irgendwie kommen Sie gar nicht mehr drum herum, sich auch auf die Fahne zu schreiben, dass Sie etwas mit Big Data machen. Andererseits geht Ihnen das Gerede um Big Data allmählich auf die Nerven. Haben all die Unternehmen, die behaupten, Big Data zu können, wirklich Big Data? Sie haben jetzt nämlich eine Weile in Ihren Datenbanken gesucht und einige gut strukturierte Daten gefunden, die für Sie auf den ersten Blick aus gutem Grund da sind wo sie sind. Aber als “Big” würden Sie diese nicht unbedingt bezeichnen. Kann man mit Ihren Daten denn trotzdem was anfangen? Haben Sie vielleicht nur nicht lange genug nach “echtem Big Data” gesucht?

Um es kurz zu halten: Unsere Erfahrung ist, wirklich “Big Data” machen nur wenige. Der Begriff umfasst die immer schneller wachsenden strukturierten und unstrukturierten Datenmassen im Unternehmensumfeld und Internet sowie deren Verarbeitung mithilfe moderner IT-Lösungen. Damit beschäftigen sich Google oder Amazon beispielsweise. Aber der Rest…?

Sagen wir, Sie, mittelständisches Unternehmen mit Tradition, haben seit Mitte der 90er ein ERP-System, welches Sie sorgfältig in Einkauf, Produktion, Vertrieb und Controlling einsetzen. Hier spielt die Analyse der Daten und die Planung eine wichtige Rolle. Sie brauchen sich nichts vorzumachen. Nicht immer wird alles richtig eingegeben. Fehler sind menschlich. Doch im Großen und Ganzen haben Sie im Laufe der Zeit doch einige brauchbare Daten gesammelt. Sie produzieren und verkaufen an die 2.000 Produkte, teils alte Kassenschlager, teils Neueinführungen. Für diese Produkte haben Sie an die 25 Jahre historische Daten zur Verfügung. Wenn man daraus Zeitreihen auf Monatsbasis kreiert, kommt man auf etwa 600.000 Datenpunkte - nicht mehr als 300 pro Zeitreihe. Big Data? Definitionssache. Letztendlich analysiert man doch meist auf der Ebene einer einzelnen Zeitreihe. In Ihrem ERP-System sind viele Daten, aber im Grunde genommen wird das Problem leicht auf eine deutlich kleinere Anzahl heruntergebrochen. Der korrekte Begriff für das, was Sie machen, wäre dann wahrscheinlich besser als “Smart Data” bezeichnet, oder eben einfach als “Advanced Analytics”. Und wenn Sie speziell Vorhersagen machen möchten, dann sagen Sie vielleicht “Predictive Analytics”.

Wie viele Daten braucht es wirklich?

Eine gewisse Anzahl an Datenpunkten zu haben, ist natürlich notwendig. Aus nichts kann ein Algorithmus nicht viel machen. Und wenn Sie Monatsprognosen machen möchten, dann wären einige Monate Datenhistorie schon gut. Besser wären sogar einige Jahre, sagen wir vier oder fünf, um eine in vielen Anwendungen häufig vorhandene Jahressaisonalität abbilden und nutzen zu können. Also 12 (für 12 Monate pro Jahr) mal 4 Jahre gleich 48 Datenpunkte. Big Data? Wohl kaum. Prognosen, die Trend und Saison berücksichtigen können? Absolut.

Natürlich wird die Auswahl an Prognosemethoden mit wenigen Daten dünner. Vermutlich müssen viele Machine-Learning-Verfahren aufgrund zu weniger Trainingsdaten dran glauben. Einige wenige bleiben, wie zum Beispiel Classification and Regression Trees, die gemeinhin zu den Machine-Learning-Verfahren gezählt werden. Immer noch zur Verfügung stehen viele statistische Prognoseverfahren. Diese haben den großen Vorteil, dass sie eine vorhandene Datenhistorie häufig deutlich effizienter nutzen können als Neuronale Netze und Co. und demnach oft mit weniger Daten auskommen, ohne viel an Prognosequalität einzubüßen. Noch dazu liefern sie in der Regel modellbasierte Informationen mit, die höchst sinnvoll eingesetzt werden können. Hierzu gehören die modellbasierte Varianz, aus der man Prognoseintervalle bauen kann, oder Informationskriterien, die zur Quantifizierung der Prognosegüte herangezogen werden können.

Eine gewisse Struktur wird sicher hier und dort vorausgesetzt. Dass die Zeitreihe aus einer Kombination von Trend, Niveau, eventuell Saison und einem zufälligen Fehler besteht, ist, etwa wie im Falle der exponentiellen Glättung, gegeben.

Eine spannende Methode, wie man bereits mit Small Data treffsichere Prognosen erstellen kann, ist ein geeigneter Transfer-Learning-Ansatz. Wie das geht, erklären wir jetzt am Beispiel Sales Forecasting.

Sales Forecasting mit Small Data

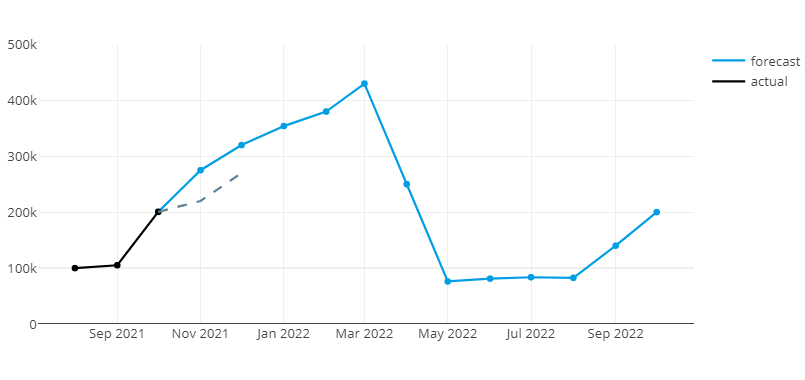

Beispiel: Ein junges Start-up-Unternehmen besitzt ein stetig wachsendes Portfolio an unterschiedlichen Produkten. Die Verkaufszahlen der einzelnen Produkte in den nächsten Monaten möglichst gut einschätzen zu können, steigert die Effizienz von internen Beschaffungsprozessen und vermeidet Lieferschwierigkeiten. Die manuelle Planung möglichst frühzeitig durch KI-gestützte Verfahren zu ergänzen, stellt die Weichen für einen höheren Automatisierungsgrad, der bei einer weiteren Unternehmensskalierung unabdingbar wird. Die Datenhistorie ist mit ca. drei Jahren (36 Datenpunkte auf Monatsbasis) relativ kurz. Viele neue Produkte können sogar mit einer deutlich kürzeren Sales-Historie vorliegen - eine Herausforderung für datenbasierte Forecasting-Algorithmen. Zudem ist aus Business-Sicht bei vielen Produkten ein ‚Gefühl‘ von saisonalen Effekten vorhanden: Suppen verkaufen sich im Winter stärker als in den Sommermonaten. Die einzelnen Suppenprodukte, z. B. Gemüsesuppe, weisen eine zu kurze oder teilweise zu volatile Verkaufshistorie auf, um diese Saisonalität in valider Weise direkt auf der Einzelproduktebene abzuleiten und für die Forecasts zu nutzen.

Transfer Learning zur Abbildung der Saisonalität bei kurzen Zeitreihen

Eine sinnvolle Strategie ist hier ein Transfer-Learning-Ansatz mit Modulation durch saisonale Transitionsfaktoren. Die Einzelprodukte werden hierbei zunächst in Produktgruppen geclustert. Auf der deutlich stabileren aggregierten Historie lässt sich ein gemeinsames Saisonalitätsmuster erkennen und datenbasiert schätzen. Über Transitionsfaktoren kann dieses Saisonalitätsmuster dann Eingang finden in Prognosemodelle, die individuell für jedes Einzelprodukt trainiert werden. Die (noch) knappe Datenhistorie gewährt wenig Raum für umfangreiche Kreuzvalidierungsstrategien und historische Simulationen. Ein agiler Ansatz ist hier genau richtig:

- Starte mit geringem Aufwand und einem Minimal Viable Product.

- Monitore die Forecast Performance im Live-Modus.

- Identifiziere Verbesserungspotentiale und priorisiere diese nach Aufwand und Nutzen. Solche Erweiterungen können beispielsweise der Einbezug von Zusatzinformation sein, etwa bereits vorliegender Bestellungen eines Produkts für die Zukunft oder die gezielte Analyse des Bestellverhaltens einzelner Kunden, die ein Produkt kaufen.

- Profitiere von der frühzeitigen Weichenstellung eines datenbasierten Vorgehens mit wachsender Datenmenge durch Zeit- und Kostenersparnis, einer sehr guten Skalierbarkeit sowie durch objektive, planerunabhängige Prognosen.

Durch agile Entwicklung zu interpretierbaren Ergebnissen

Wenn man auch manchmal Nicht-Standard-Analysetechniken anwenden muss und Zusammenhänge und Interpretationen der Daten noch genauer ansehen und einsetzen muss, kann man auf kleinen Datenmengen durchaus robuste Modelle und wertvolle Prognosen bilden. Nebenbei haben Small-Data- ggü. Big-Data-Lösungen den Vorteil, dass die Modelle oft anschaulicher und besser interpretierbar sind als typische Big-Data-Modelle, die so manches Mal als Blackbox erscheinen. Außerdem zwingt Small Data den Anwender gewissermaßen zu einem agilen Entwicklungsansatz, der bei datenbasierten Lösungen sowieso oft empfehlenswert ist. Gemeinsam mit den Datenmengen kann auch die Lösungsstrategie wachsen und sich jederzeit geeignet auf die veränderte Datenlage anpassen. In vielen Fällen kann es damit sogar eine bewusste Entscheidung sein, Big Data statt Small Data zu analysieren, und sich gezielt auf eine bedeutungsstärkere, evtl. transformierte, Datenteilmenge zu konzentrieren, dem bereits oben genannten Stichwort Smart Data. Es lohnt sich also, auch mit kleinen Datensätzen zu arbeiten. Dennoch sollte man die Chance des größer werdenden Datensatzes nicht verpassen. Mehr Daten tragen doch zumindest potentiell mehr Informationen in sich, und man hat dann immerhin die Wahl, wie man mit den Daten umgehen möchte.

Weitere Anwendungsmöglichkeiten von Small-Data-Techniken

Nicht nur im Bereich des Sales Forecasting kann man mit Small Data schon viel anfangen. Auch in folgenden Bereichen können Ihnen Small Data begegnen - und eine passende Lösungsstrategie ist meist nicht weit.

- Sales Forecasting / Demand Planning / Logistik / Produktion: Oft liegt eine kurze Datenhistorie oder ein kurzer Lebenszyklus von Produkten vor.

- Monitoring und Anomalie-Erkennung: Maschinenausfälle, die möglichst frühzeitig über charakteristische Patterns aus Sensormessung identifiziert werden können, sind idealerweise seltene Vorkommnisse, sodass meist nur wenige historische Trainingsbeispiele zur Verfügung stehen.

- Computer Vision: Bei der Bildklassifikation mit Neuronalen Netzen gibt es gelegentlich nur eine geringe Anzahl an vorliegenden Beispielbildern.

- Finance / Umsatz: Anstatt direkt mit Big Data (viele Redundanzen) zu arbeiten, ist es oft von Vorteil, über Dimensionsreduktionstechniken den Informationsgehalt der Daten in passenden aggregierten Größen zu kondensieren. In simpelster Form kann das z. B. eine Aggregation auf ein hohes hierarchisches oder zeitliches Level sein. In vielen Fällen ist es eine gute und sinnvolle Entscheidung, bewusst von Big Data zu Small Data überzugehen.

- Klinische & soziologische Forschung: Die Fallzahl in Studien ist begrenzt auf Grund von ethischen Aspekten, seltenen Krankheitsbildern, personellen Kapazitäten (Datenerhebung) etc.

Unser Fazit: Wenn in Zukunft mal wieder von großen Daten die Rede ist - Big Data ist oft Small Data auf den zweiten Blick und die richtige Herangehensweise ist weit wichtiger als der Umfang an Daten.

Infobox:

Classification and Regression Trees (CART): Vom amerikanischen Statistiker Leo Breiman geprägter Begriff für Entscheidungsbaum-Algorithmen, bei welchen über Binärbäume die Klasse, zu der Daten gehören, oder ein Wert bestimmt werden. Im Fall der Zeitreihenvorhersagen folgt aus dieser Klasse oder dem Wert die Prognose. Diese Verfahren werden auch häufig im Machine-Learning-Bereich eingesetzt und dienen als Grundlage für Random Forests.

Sie haben auch kurze Zeitreihen und möchten wissen, ob Sie damit Vorhersagen machen können? Finden Sie es mit unserer Hilfe heraus: